多任务学习

好处

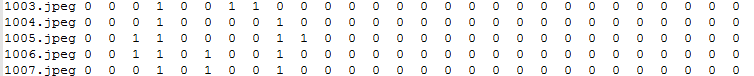

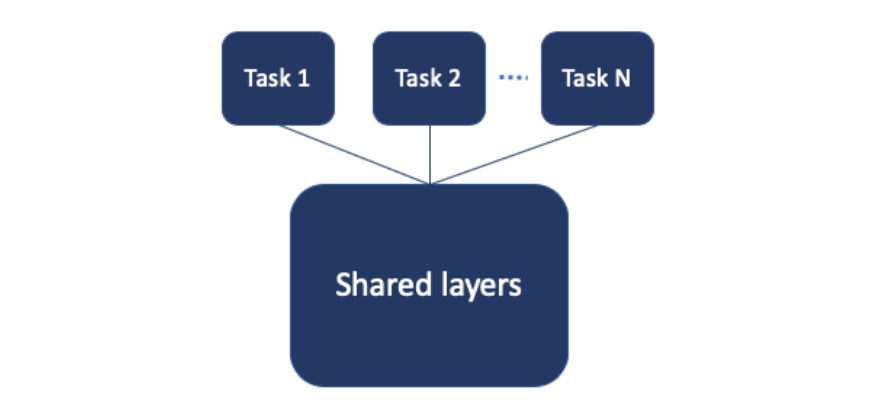

1 多个模型一起训练

2 可以提升单一任务的效果

微软的MT-DNN[33]已经证明基于预训练模型的多任务Fine-tuning可以提升各项子任务效果

结构

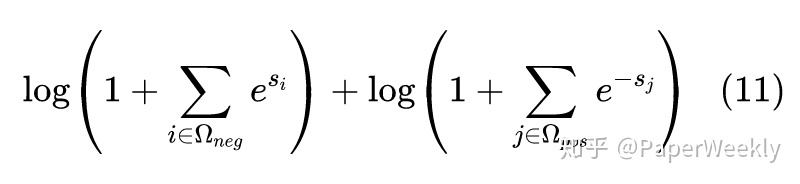

loss

设计loss是重点

除了各个子任务的损失直接相加,还有别的方式吗

辅助任务怎么设计

问题

辅助任务??

参考

https://zhuanlan.zhihu.com/p/397196665

https://tech.meituan.com/2020/07/09/bert-in-meituan-search.html