catboost(categorical boosting)

1.原理

https://zhuanlan.zhihu.com/p/540956200

https://arxiv.org/pdf/1706.09516.pdf

https://zhuanlan.zhihu.com/p/108110195

1.Categorical feature

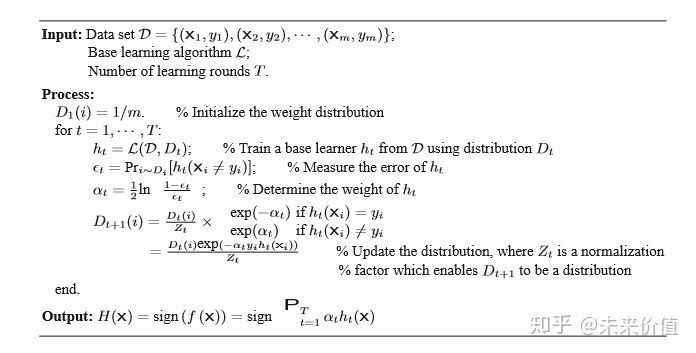

2.Ordered boosting

预测

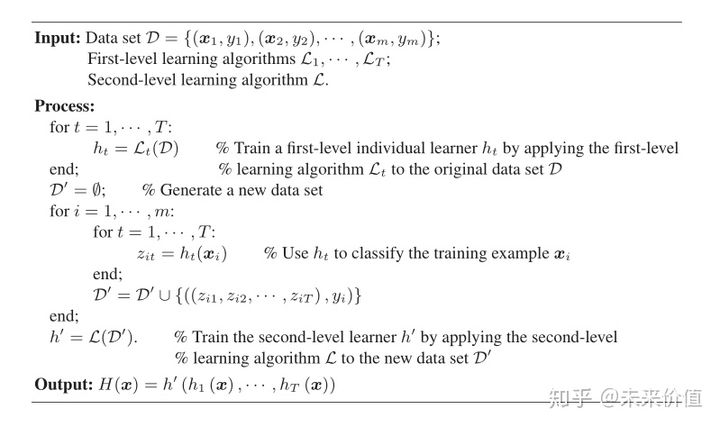

多棵树组合

xgboost,lightgbm,catboost对比

1.类别特征处理

xgboost:不能直接处理

lightgbm:内置,会有target leakage问题

catboost:内置, 没有target leakage问题

2.训练速度

lightgbm>catboost>xgboost

3.过拟合处理

xgboost,lightgbm:调参解决

catboost:利用Ordered boosting防止过拟合

2.使用

查看节点分裂

model.get_borders()

特征重要性

get_feature_importance

特征选择

select_features

树可视化

plot_tree

调参

分布式训练

catboost-spark